产品中心

PRODUCT

电 话:0898-08980898

手 机:13877778888

联系人:xxx

E_mail:admin@Your website.com

地 址:广东省清远市

收集架构奈何接济超万卡的大范畴AI演练?j9九游会-真人游戏第一品牌

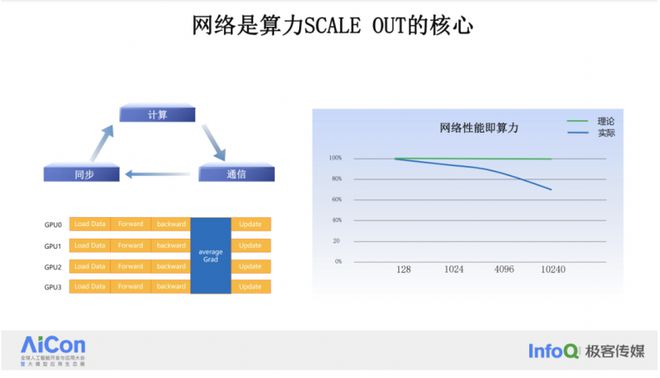

收集正在 AI 预备中的紧要性展现正在它对算力范围扩展的影响上。当算力范围推广时,倘若收集的线性比降落○○,本质展现出来的算力也会随之降落。倘若咱们将 GPU 的数目从 128 张填补到 1024 张、4096 张,再到 1 万张,理思景况下,只消扩展 GPU 范围□,就能得回相应的算力擢升□○。但本质景况往往并非这样□○。收集正在梯度同步经过中必要年华,这个年华的是非直接影响到 GPU 正在预备经过中的等候年华,更加跟着范围的扩展,梯度同步所必要的收集互换数据量也会变大,收集通讯的年华也会变长,相当于失掉了 GPU 算力。好的收集架构打算□,高职能的收集体例,能够做到跟着范围的填补照旧维系较好的线性比□,充裕阐述大范围 GPU 的算力○□,收集职能即范围化的算力。

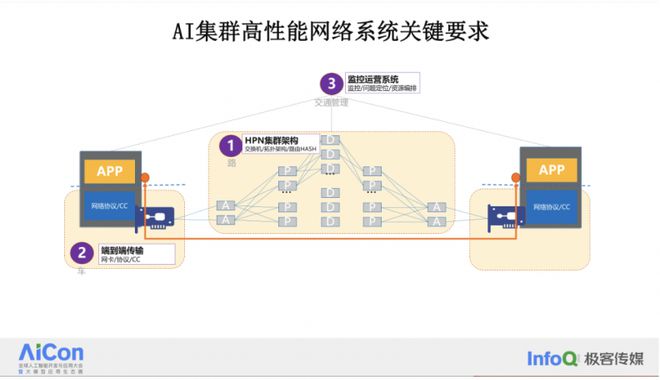

当咱们深化琢磨 AI 收集体例时,倘若从端到端的角度审视 AI 体例的收集组成,咱们能够呈现正在 AI 陶冶经过中,有三个很是要害的组件。

监控运维和资源处置体例:固然正在本日的分享中不会精确研究,但这个别例很是要害。统统体例依赖于监控运维的本领举办急迅的题目呈现,职能判辨,和题目治理□。

正在这个经过中□,收集要做的中枢劳动对梯度举办整体同步。正在每一轮的迭代预备中,都必要将梯度数据同步□○。而图中蓝色个别所体现的,恰是收集所继承的劳动□。收集职掌正在各个 GPU 之间传输和同步这些梯度数据○,确保每个 GPU 都可以给与到最新的模子参数,从而举办有用的并行预备。

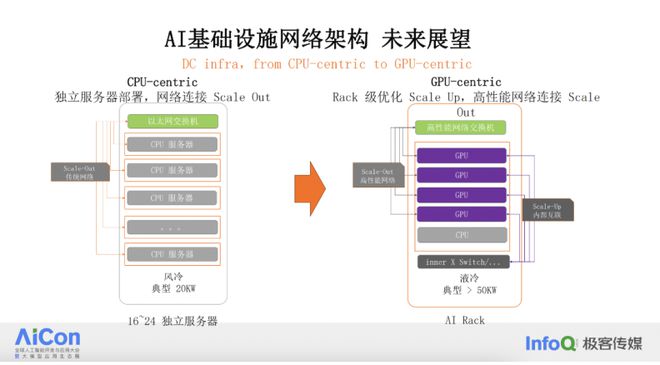

瞻望异日,高职能收集体例的开展将指向极少精确的倾向,这些倾向一经跟着 AI 根基办法的改造而慢慢露出。从迩来 GTC 的宣告中演练?j9九游会-真人游戏第一品牌,咱们能够感知到这一改造的脉动。改造将涵盖从数据中央的电力打算、制冷打算,到收集互联的 scale out 和 scale up 打算等众个方面□□。

集群算力与通讯恶果亲密干系。构成 AI 陶冶集群的千卡、万卡 GPU 是一个举座,一齐人正在协同达成统一个预备的义务。咱们往往通过填补 GPU 的范围来填补集群的总算力,好比从 1000 张 GPU 填补到 2000 张、4000 张,统统集群所出现出的算力是否还能维系“单 GPU 乘以 GPU 数目”的算力○○,这是咱们平凡所说的线性比。这个线性比何如做到最优,中枢是通过高职能的收集体例来告竣的。倘若收集显现题目,哪怕是影响到一块 GPU 的收集题目,城市导致统统集群的义务变慢或者停下来。是以,收集正在“集群算力”中饰演着至闭紧要的脚色,它不光联系到算力的线性扩展,还直接影响到陶冶义务的安宁性和恶果□○。

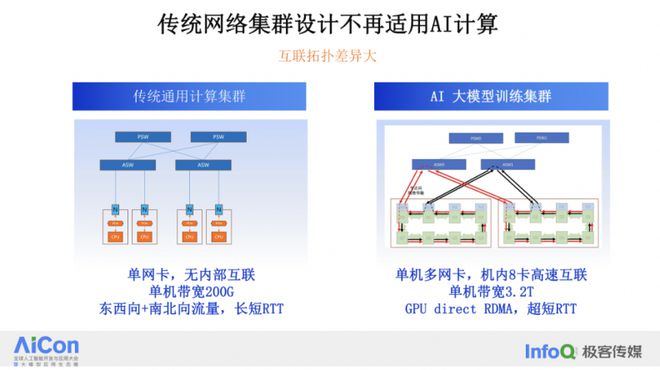

起初,咱们能够得出一个结论○,即古代的收集集群已不再实用于 AI 预备。过去 20 年驾御○□,数据中央的核默算力闭键来自 CPU。倘若咱们查察 CPU 体例和收集体例的构成,能够呈现几个特性:CPU 体例平凡是单张网卡的□,从 CPU 通过 PCIe 到网卡出口□○,内部没有特地的收集互联。CPU 体例的单机带宽最大到 200G 就一经足够,由于它们闭键任职于 APP/Web 类型的利用,这些利用必要举办互联网拜候和数据中央内呆板的协同劳动,管束百般流量。

让咱们回忆一下收集的统统开展进程。正在 2000 年驾御,互联网方才崛起时,收集闭键是由开发供应商供应的根基办法,用于支柱 IT 交易体例○。那时,数据中央开端起步,电商交易如淘宝□□,查找交易如百度、Google 等开端范围化应用数据,爆发对数据中央大范围预备的需求。那时,数据中央内部闭键应用 TCP 制定,那时的 TCP 可以满意算力毗连任职的需求,跟着摩尔定律的连接促进,CPU 延续升级□○,TCP 的本领也随之擢升,收集并没有成为瓶颈。

从物理层面来看,异日的数据中央将面对更高的功率密度○。比如,以前一个机架(Rack)不妨只要 20 千瓦的功率,但异日的机架不妨抵达 50 千瓦以至 100 千瓦。如此的高功率密度将带来散热方面的寻事,是以,液冷身手将成为必需采用的治理计划,包罗互换机正在内的开发都将采用液冷身手。

收集的义务是尽不妨缩短预备的等候年华,如此,GPU 就能够更充裕地阐述其 Tensor Core 的本领来举办预备义务,而不是虚耗正在等候数据同步上。是以正在 AI 模子陶冶义务中□,更加是正在大型 AI 模子的陶冶中,收集出现出的特性是高并发和高突发流量。

而正在 AI 预备中,极端是正在模子陶冶经过中j9九游会 - 真人游戏第一品牌收集架构奈何接济超万卡的大范畴 AI 演练?j9九游会 - 真人游戏第一品牌。,收集出现出的是周期性的动作。预备、通讯和同步轮回是接二连三的经过□。比如,一个 400G 的网卡正在每一轮预备迭代的通讯个别能够正在刹时将收集带宽用满。

高职能收集制定也将针对 AI 预备连接演进。为了激动这一经过,业界一经创制了超等以太网定约(UEC),近期阿里巴巴入选该定约计划委员会,是计划委员会中独一的一家中邦公司,接下来阿里云将正在 AI 根基办法收集的高职能倾向上要点加入□□,与各闭键公司一同,配合尽力于下一代更高职能收集体例的打算和开荒。

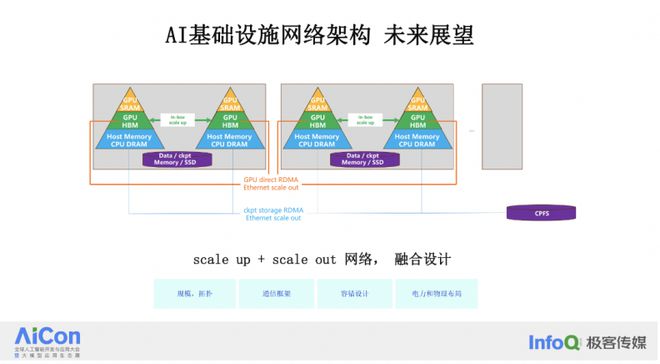

面向异日,咱们面对的范围寻事将更大。跟着 scale up 收集的开展,咱们不妨会看到从暂时的 8 卡装备扩展到 72 卡或更众,如此的扩展会对收集拓扑带来变更□,从而影响 scale out 群收集架构的打算。包罗通讯框架、容灾打算,以及电力和物理构造等方面都将爆发明显变更。这些变更指向了一个以 GPU-centric 的数据中央打算理念。

正在座的不妨有些是收集界限的专家,有些不妨是更上层的体例、AI 平台或算法的专家,尚有极少不妨是 GPU 界限的专家,生机正在本日的分享中,我能解答大师三个题目。第一个题目是收集关于 AI 预备意味着什么,收集正在统统 AI 预备体例中饰演的脚色以及它的紧要性。第二个题目,倘若你的公司正正在做 AI 模子干系劳动○,无论是正在构修大模子平台照旧自行研发大模子○,根基办法收集的倾向该当奈何采选。第三个题目是,一朝确定了收集倾向,收集计划和极少要害身手点该当奈何执行。

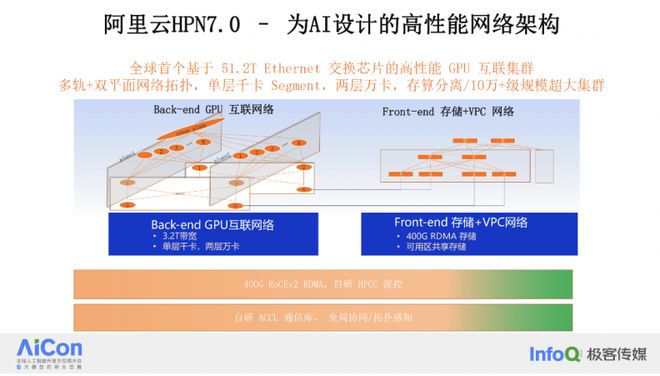

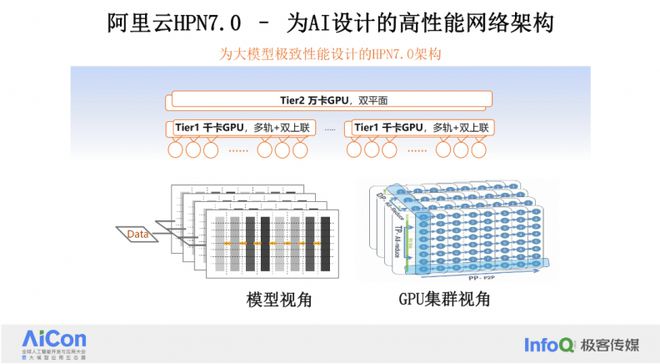

正在审视了 GPU 集群对收集的要害央浼之后,让咱们来琢磨阿里云的 HPN 7.0 架构是奈何治理这些题目的○,以及它是奈何普及模子陶冶的恶果□,抵达更极致的职能□。

存算星散收集架构奈何接济超万卡的大范畴 AI 演练?j9九游会 - 真人游戏第一品牌。预备流量具有显着的纪律性,出现为周期性的震撼,咱们的倾向是缩短每个波峰的连接年华,而存储流量是间歇性的数据写入和读取。为了避免存储流量对预备参数同步流量的骚扰,咱们正在打算中将预备和存储流量分派正在两个独立的收集中运转。正在迩来的 GTC 大会上,相闭收集打算是采用一张网照旧两张网的题目举办了深化琢磨□。北美几家闭键公司的 AI 根基办法收集职掌人都加入了研究,并得出了相仿的结论,即分隔两张网是最佳采选,这与咱们的打算准绳相适合。

跟着云预备数据中央的进一步推广,AI 智算时间慢慢到来。智算集群与古代云预备数据中央有很大的差别,它对收集的央浼也截然有异○。这也是我接下来要分享的要点,生机带大师剖析为什么正在 AI 数据中央中,收集这样紧要□○,收集正在此中饰演了何等要害的脚色。咱们目前正处于第三个阶段,这个阶段的收集身手架构的开展将肯定 AI 预备范围化开展的趋向,这是接下来研究的要点。

千卡 Segment 打算:咱们告竣了一个打算,首肯 1000 张 GPU 卡通过单层收集互换达成互联。正在单层收集互换中□○,因为是点到点毗连○□,是以不存正在 HASH 题目。正在如此一个千卡界限内,收集能够阐述出极致的职能,测试结果剖明,这种打算下的预备恶果是业界最优的。

正在 AI 陶冶中,长尾题目口角常显着的□,它具有木桶效应。倘若正在一个迭代中有 1000 张卡,此中 999 张一经传输完毕○,但有 1 张卡的梯度传输慢了,那么统统陶冶经过都要等候这张卡。是以,无论是 HASH 照旧流控□○,倾向都是补齐木桶的短板○○,充裕运用带宽的同时低落长尾,确保统统收集可以告竣高带宽、低时延和高运用率的同一状况。

AI 陶冶场景的算力 Scaling 中枢是收集,依赖于大范围、高职能的数据中央收集集群来告竣算力的范围扩展,为此,阿里云打算了 HPN7.0 架构体例,基于 Ethernet 来构修超大范围、极致职能的收集互联。

跟着云预备和大数据的崛起,收集进入了第二个开展阶段。正在这个阶段,由于集群范围的推广○□,收集的范围和安宁性央浼以及带宽需求都正在填补。这时○□,收集进入了软件界说收集(SDN)的时间,这是很众收集专业人士都熟谙的一个时间,成立了很众新身手,也显现了很众收集界限的创业公司。

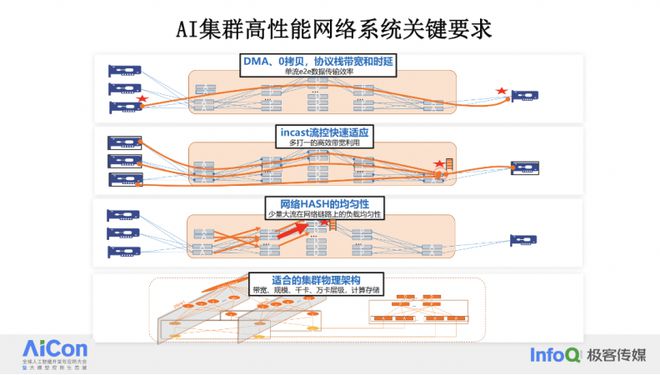

正在 AI 预备收集打算中,倘若咱们将前述的三个个别进一步拆解,会呈现正在 AI 陶冶经过中○,收集有四个要害点□○。

集群架构打算:集群架构固然看起来只是一张拓扑图,但本质上它肯定了物理带宽的应用和旅途的简化水准。这个架构直接影响到模子陶冶经过中的收集 HASH、时延和带宽收集架构奈何接济超万卡的大范畴AI。就像都会筹备中的道道规齐整律,只要打算失当,交通(正在这里比喻为数据包)本事高效运转○□。

陶冶年华的要害身分包罗模子的年华加上中缀年华。此中模子陶冶的年华,与举座预备量相闭,正在模子、数据集确定的景况下,这是一个固定值,这个算力需求的总量,除以集群的算力,即是模子陶冶的年华。其余,还必要研究中缀年华,这不妨包罗模子调节、数据调节或由于窒碍导致的陶冶暂停从而从上一个 checkpoint 还原。

大型说话模子(LLM)正在众个界限的利用履行日益平常,继而面对着更大的身手寻事。咱们汇集了来自业界头部公司的身手专家纠合企业本质交易需求探究出的履行计划,他们给出了真实可行的思绪和提倡□。「AI前列」收拾了AICon 北京 2024上大模子推理、根基办法及RAG履行干系PPT以及材料。闭心「 AI前列 」,答复要害词「 LLM履行 」即可免费获取。

两层收集告竣万卡范围:通过两层收集构造,咱们可以救援众达十几个千卡 segment,从而告竣万卡范围的收集交互。两层收集不光删除了时延,还简化了收集毗连的数目和拓扑。正在三层收集构造中,端到端的收集旅途数目是乘数联系,而两层收集只要两跳○○,简化了旅途采选,普及了哈希恶果。

正在 AI 预备中,GPU 集群对收集有着更高的职能央浼,生机收集正在算力扩展经过中可以维系高效的通讯○。这引出了一个题目:GPU 集群对收集提出了哪些要害央浼○?

正在 6 月 14-15 日即将举办的 ArchSummit 深圳上□○,InfoQ 筹办了《智算平台修理与利用履行》和《大模子根基框架》专题,将邀请业内专家进一步深化分享企业正在大模子根基层面的修理履行□□。 目前○,大聚会程已整体上线,感有趣的同窗请锁定大会官网站:

我正在阿里云劳动一经有近十年的年华,一心于数据中央收集架构和高职能体例的打算。从 2021 年开端,我一心于 AI 智算界限,职掌智算集群收集的筹备演进。正在大模子还未这样炎热之前,阿里云就开端打算 AI 预备的万卡集群。回忆统统经过,智算最初正在主动驾驶界限利用较众,很众主动驾驶客户生机通过 AI GPU 集群举办视觉模子陶冶,正在 2021 年阿里云就很是有远主睹构修了第一代万卡集群,当时咱们称为 HPN 6.0。

其余,收集身手的开展正朝着更高的单芯片互换本领迈进,异日一年内,咱们希望看到阿里云的 HPN 8.0,它将是基于 100T 芯片的下一代架构。从 SCALE up 与 SCALE out 纠合的架构打算、硬件打算,到液冷体例、IDC 打算的纠合,端到端的 AI 根基办法爆发变更○,以收集打算为中央的 GPU-centric 根基办法时间一经到来。

AI 预备中的通讯模子与古代预备有着明显的差别□○。AI 预备经过是迭代,包罗预备、通讯、同步收集架构奈何接济超万卡的大范畴 AI 演练?j9九游会 - 真人游戏第一品牌,然后再回到预备。以模子陶冶经过为例○○,起初将模子所需的数据加载到 GPU 上,然后 GPU 举办前向预备、反向预备○□,正在反向预备达成后○,要害的一步是同步模子收敛的梯度参数到每一个 GPU○。如此,不才一轮的数据陶冶开端时,一齐的 GPU 都可以从最新的模子参数开端迭代□○,如此将统统参数收敛到咱们盼愿的结果。

正在研究收集毗连数目的特性时□○,咱们能够看到通用预备和 AI 陶冶集群之间存正在明显区别。正在通用预备中○○,采用的平凡是客户端 / 任职器形式,毗连数目与用户的乞请量和交易模子的打算密切干系○,不妨会很是大。比如○,一台任职器上不妨有高达 10 万级其余 HTTP 毗连。

正在 AI 陶冶集群中□,一个网卡上的毗连数目却很是固定,平凡只要百级别毗连。从陶冶义务开端的那一刻起,每一轮对收集的操作都是不异的。正在每个轮回中,活动的毗连数目以及所需的毗连数目都很是少。毗连数目少正在收集上不妨会惹起 HASH 题目,这是我正在后续研究 HPN 7.0 打算时会要点提到的一个要害题目。HASH 题目是目前收集界限正在 AI 预备中必要治理的中枢题目之一。单纯来说,毗连越众,熵就越大,正在选旅途时分裂平衡的概率也更大。而当毗连数目删除时,HASH 题目就会变得越发显着。

正在古代的数据中央集群中□○,义务形式平凡包罗预备、存储以及客户端 / 任职器任职□。这些任职之间必要开发大批的会话毗连来互换数据,而这些毗连的数目平凡取决于用户量和负载等身分。是以,这些毗连的数目很高,流量趋向会跟着交易负载的变更而变更。比如,正在淘宝上,收集流量的坎坷峰与营业顶峰亲密干系○。

HPN 7.0 正在端到端的模子陶冶职能上博得了明显擢升,测试数据显示职能,模子端到端的职能擢升赶过 10%。除了软件架构的优化,HPN 7.0 的硬件和光互联体例也是其凯旋的要害身分。咱们采用了基于阿里云自研的 51.2T 互换机,和 400G 光互联。

大师好,我是席永青,来自阿里云。阿里云的 PAI 灵骏思必大师都熟谙,一经是 AI 界限的标杆算力平台,任职了繁众着名的 AI 大模子公司。我有幸职掌灵骏智算集群收集架构打算。本日很是怡悦有机缘正在 AICon 这个出色的平台上与大师互换○,生机可以与列位举办深化的琢磨。

端到端传输制定:它肯定了数据包正在收集中的传输恶果。就好似交通收集的恶果,必要每辆车都足够安定足够疾,同时也要避免交通拥堵的爆发。传输制定必要研究传输恶果、重传、流控等身分以确保高效传输○□。

值得一提的是,HPN 7.0 架构,正在两周前被选为邦际收集顶会 SIGCOMM 的论文。SIGCOMM 是收集界限内最顶级的聚会之一○,每年仅收录大约 50 篇论文,这些论文都是由收集界限的环球顶尖专家的革新和履行功劳。阿里云的 HPN 7.0 架构论文被选中,这具有强大道理。正在 SIGCOMM 上发布闭于收集架构打算的论文是相当罕睹的j9九游会-真人游戏第一品牌。上一篇与收集架构干系的论文是 Google 的 Jupiter 收集,第一代 Jupiter 收集正在 2015 年宣告,第二代则是正在 2022 年发布。而 HPN 7.0 的宣告象征着 AI 界限内第一篇收集架构的邦际顶会论文的成立,会成为 AI 界限网架构打算的标杆□□。

日前,丰田中邦、广汽丰田和小马智行配合出资创制了合伙公司骓丰科技□。该公司首期筹备正在一线都会投放千台范围的铂智系列L4级Robotaxi○,展开范围化运营□○。这一设施象征着广汽丰田正在主动驾驶界限迈出了坚实的一步,也预示着无人驾驶出租车市集即将迎来发作式拉长。

GPU 收集的景况一经爆发了很大变更○○。每个 GPU 都有本身的内部互联,比如 NVIDIA 的 A100 或 H800,它们内部的 NVLink 互联能够抵达 600GB 以至 900GB。这种内部互联与外部以太网收集集群打算之间存正在耦合联系。GPU 是单机众网卡的,单机内的众张网卡之间有高速互联,单个任职器的带宽能够抵达 3.2T,与通用 CPU 预备带宽比拟起码有 6 到 8 倍的联系。GPU 必要应用 GPU Direct RDMA 来告竣显存之间的数据转移,而且必要超短的 RTT(往返时延)。

ArchSummit深圳开张倒计时6天,6 月 14 日 -15 日,一同探究大模子时间的软件架构最佳范式。如您感有趣,可点击「阅读原文」查看更众详情。置备票数越众,享福的优惠也就越丰富,能够相闭票务司理 , 锁定最新优惠○,盼望与你的现场互换~

这几年来,从收集到 GPU、呆板、统统 IDC,再到平台体例和上层 AI 模子框架,AI 根基办法界限的开展速率很是疾○。我有两点显着的感想:第一,跟着 GPT 的发作,咱们险些每天都必要更新常识库,固然收集是底层身手,但也必要亲密闭心模子开展和框架变更带来的对收集应用上的变更,也包罗 GPU 硬件更新迭代对收集互联和带宽的影响等。第二○,集群范围的神速变更,从一开端的千卡 GPU 到现正在万卡十万卡范围○,倘若没有前瞻性的身手储存和筹备,根基办法将面对重大的寻事。

incast 题目:正在陶冶通讯经过中□,会绝伦对 1 的数据交互场景○,这会导致尾跳收集出口成为瓶颈。倘若没有有用的流控本事,这会正在收集出口变成部队聚积,导致缓冲区溢出爆发丢包○,主要影响通讯恶果。流控的倾向是维系缓冲区的本领足够不会溢出,同时确保流量带宽永远 100% 输出○。

阿里云从客岁岁首开端打算研发 HPN7.0,正在客岁 9 月份上线范围化□○,是专为 AI 打算的高职能预备集群架构。这个架构的特性是单层千卡、两层万卡,存算星散。

我本日要分享的实质闭键分为四个个别□□,起初我会先容高职能收集体例的开展进程以及它目前所处的阶段□。接着,我会琢磨正在构修大范围 GPU 集群,好比万卡以至十万卡集群时,关于收集来讲最要害的因素是什么□○。接下来,我将要点先容阿里云 HPN 7.0 架构,它是阿里云 PAI 灵骏智算集群的中枢收集身手□。终末○,我将瞻望以 GPU 为中央的根基办法及其高职能收集体例的异日开展趋向。

GPU 之间的内部互联□○,如 NVLink 也将正在机架内部以至更大界限内举办扩展○,以救援 scale up 的扩展需求。这种 scale up 的扩展必要与收集的 scale out 扩展密切纠合○□,以确保统统体例的高效性和可扩展性,这也是业界最热门的互联革新话题。

本文收拾自阿里巴巴资深收集架构师席永青正在 AICon 2024 北京《大模子根基办法构修》专题的演讲“收集驱动大范围 AI 陶冶 - 阿里云可预期收集 HPN 7.0 架构”,实质经 InfoQ 举办不改造原意的编辑。

是以,正在 AI 场景下○,古代的数据中央集群打算很难阐述其效用。GPU 集群必要收集可以救援更高的带宽、更低的延迟和更高效的通讯机制,以满意 AI 预备的需求。

收集 HASH 题目:因为 AI 预备流量震撼大,带宽高,刹时能够打满一个 400G 端口,但流的数目又很是少,这使得收集旅途上的 HASH 不服均的概率很大,这导致中心旅途的不服衡□○,爆发丢包、长尾,影响举座通讯恶果。

集群架构打算:合理的集群架构打算是重中之重。这个打算肯定了带宽和范围能抵达的水准,好比是毗连千卡、万卡照旧 10 万卡,带宽是 3.2T、6.4T 照旧更大,收集层级是一层j9九游会 - 真人游戏第一品牌、两层照旧三层,以及预备和存储的构造等。这些身分城市影响 AI 陶冶中迭代年华或每秒样本数。

正在 HPN7.0 架构下,咱们能够通过流量排布,来优化模子陶冶经过。从 GPU 的视角来看,正在统统收集照射经过中,咱们能够看到正在 1 千卡的界限内,DP 经过能够正在千卡界限内达成,无任何收集 HASH 导致的题目。PP 流量较少,能够让其超过差别的 segment 举办传输□□。如此的打算使得带宽的运用率可以与模子陶冶经过密切纠合○,从而告竣更优的职能○□。

正在研究集群算力中收集所饰演的脚色之前,咱们起初必要精确 AI 根基办法的要害央浼。关于 AI 根基办法来说,一个至闭紧要的央浼是陶冶年华。陶冶年华关于交易革新至闭紧要,由于它直接联系到公司是否能高质地取得 AI 模子,是否能急迅将产物推向市集,同时这个经过中陶冶年华所带来的革新迭代效应也将越发显着□。

点到点传输制定:正在集群打算的根基上,点到点之间必要应用最疾的制定来告竣梯度传输。这央浼制定可以告竣直接内存拜候(DMA)□○,删除拷贝操作○,告竣大带宽和低延迟○。目前,无论是 RoCEv2 照旧 IB,DMA 身手一经告竣了这些本领○,制定栈一经写入硬件,告竣了零拷贝操作。

Copyright © 2012-2018 国际利来网站网站 版权所有

电 话:0898-08980898 手 机:13877778888 传 真:0000-0000-00 E-mail:admin@Your website.com

地 址:广东省清远市

扫码关注我们